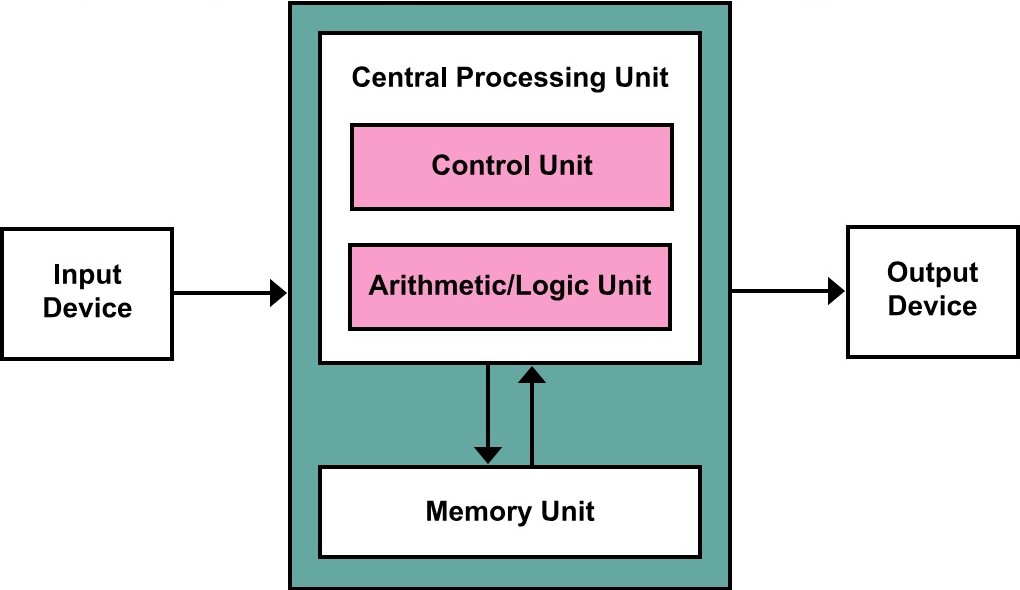

Je sais que c’est scandaleux, ça fait très longtemps que je n’ai pas écrit. On va essayer de remédier à ce point aujourd’hui. Ce blog va être consacré aux Processeurs. Tant mieux, c’est mon principal sujet d’étude en académie. La vidéo ci-dessus liste les principaux processeurs existants dans le marché du PC. Mais avant cela, j’aimerais soulever un point concernant la liaison toujours faite entre processeurs et Architectures. Pourquoi, lorsqu’on parle toujours des processeurs on inclut généralement le terme architecture. Le terme architecture signifie généralement l’organisation et la structure électronique à l’intérieur d’un ordinateur. Mais ce terme avec le temps a évolué, incluant un aspect important des processeurs. Et avec le temps, le terme architecture commence à définir la vision du Hardware par le Software, sans aborder l’aspect structurel de l’architecture. Ça veut dire que Architecture ne signifie plus comment l’électronique est structurée à l’intérieur d’un ordinateur, mais plutôt comment les informations nécessaires et suffisantes fournies au Software peur exploiter le hardware, tout en ignorant la structure interne. De nos jours, généralement lorsqu’on dit le terme architecture, on va parler de la taille des instructions, des registres, la taille de la mémoire, la taille du bus de données, le mot mémoire, le jeu d’instructions…etc. Et comme vous pouvez l’observer, ces caractéristiques sont souvent liées au processeur. De l’autre côté, un nouveau nom est maintenant utilisé pour désigner spécifiquement la description de la structure interne électronique d’un ordinateur. Ce mot c’est Computer Organization, ou parfois Micro-architecture.

La vidéo de l’excellente chaîne YouTube NextGen Explained dédiée aux nouvelles technologies, illustre une liste des principaux processeurs actuellement utilisés pour les PCs. Ça montre en gros, la chronologie de l’évolution de ses processeurs dans le marché des Ordinateurs Personnels.